淘寶為什么禁止百度爬蟲但是用戶還是能搜到呢

所有網站的robots文件都是公開的,假如輸入“網站域名/robots.txt”打開了一個404錯誤頁面,則說明該網站沒有做robots文件。

robots文件是搜索引擎蜘蛛來一個網站首先要查看的,提前知道該網站哪些答應它抓取,哪些不答應的,它會遵循規定來做。假如不做robots文件,在該網站的空間日志里會出現一個404的錯誤代碼,這不要緊,因為很多網站都不做,尤其對于小型網站并不重要。但大型網站講究比較細致,基本上都會做。

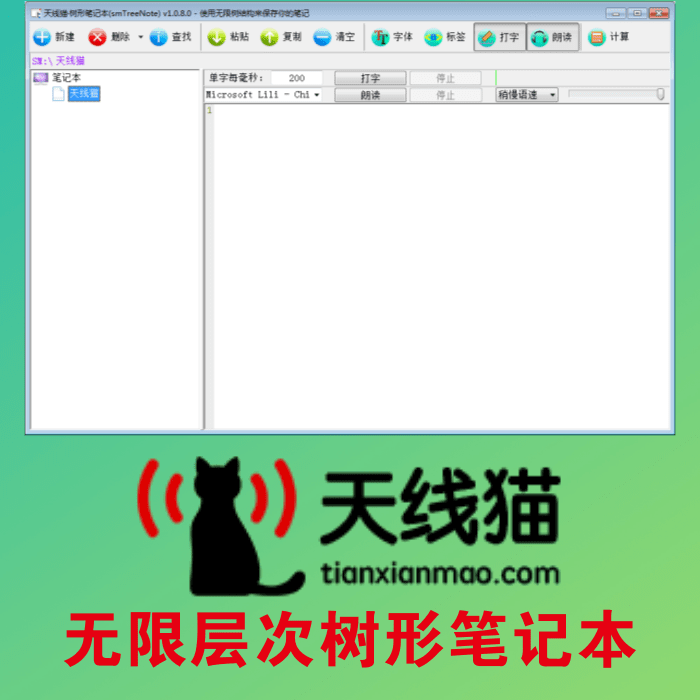

下圖中淘寶的robots文件表示禁止百度蜘蛛抓取網站的任何內容,有人會問“我搜索淘寶網,明明可以搜到,難道是淘寶寫錯,或百度沒有遵守這個規則?”這里天線貓seo的小編要說明兩點:

(1)淘寶并沒有寫錯

(2)百度有時候的確會不遵守規則,包括其他搜索引擎也是如此。

搜索引擎并不會完全遵守robots文件,但總體來說都是遵守的。有些文章已經被百度收錄了,假如臨時要用robots文件屏蔽它們,那么在百度的數據庫里大概需要幾個星期到一兩個月的時間才能慢慢刪除這些文章。

為什么淘寶網一直在百度里呢?并不是百度不遵守規則,而是從用戶體驗的角度來講,假如一個網民去百度搜索“淘寶網”,很后竟然搜索不到,他會認為百度這么大一個搜索引擎居然搜索不到這個知名的淘寶網,非常希罕。所以像淘寶網這種非常知名的網站,百度對它比較尤其,或者說是從用戶體驗的角度出發,讓網民能搜索到這類知名的網站,哪怕淘寶的robots文件里禁上百度抓取。

下一篇:淘寶代付款天貓淘寶怎么找人代付

如果您覺得 淘寶為什么禁止百度爬蟲但是用戶還是能搜到呢 這篇文章對您有用,請分享給您的好友,謝謝

文章地址:http://www.brucezhang.com/article/online/6392.html

文章地址:http://www.brucezhang.com/article/online/6392.html